Apache WebServer는 mod_proxy라는 모듈에서 forward proxy, reverse proxy 두가지 기능을 제공

NginX는 필요한 기능만 제공하는 고성능 웹서버로 reverse proxy기능만을 제공

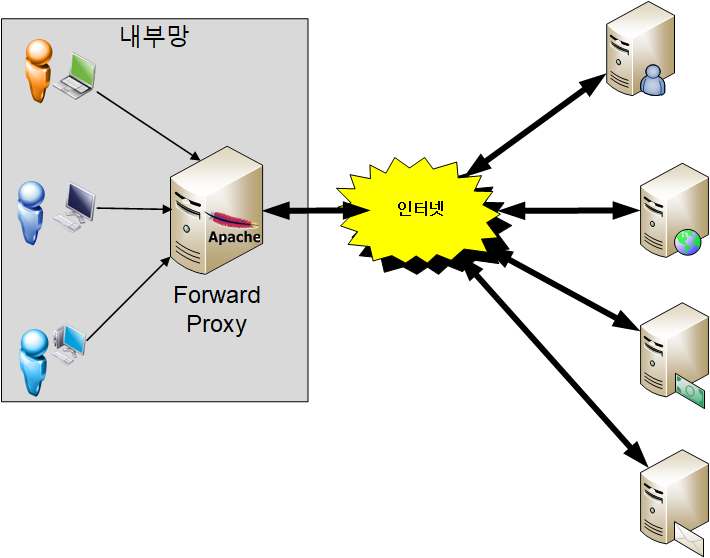

Forward Proxy

- 사용자가 다른 사이트로 연결을 하려면 사용자 ↔ 서비스 가 바로 연결되는 것이 아니라 중간에 Forward Proxy를 거쳐서 연결이 된다.

- 캐시 기능이 있어 성능에 좋다.

- 보안이 좋다.

- 정해진 사이트만 연결하게 설정할 수 있어 보안이 중요한 기업 환경에서 많이 사용된다.

- 기관에서 사내 네트워크를 관리할 때 사용한다고 생각하면 된다. 인터넷 사용에 제한을 두어서 보안에 유의할 수 있도록 해주는 역할

Reverse Proxy

사용자가 example.com 웹 서비스에 데이터를 요청하면 이 Reverse Proxy가 요청을 받고 내부 서버(WAS)에서 데이터를 받아 다시 전송하게 됩니다.

웹 서버의 앞에 두어서 로드밸런싱 역할을 수행할 수 있다.

장점

- 보안

- WAS를 최전방에 두게 된다면? WAS가 해킹을 당하면 관련 서버와 DB까지 모두 해킹당하는 심각한 보안 문제가 생긴다.

- 웹 서버만 내부 WAS와 연결하도록 설정하면 웹 서버가 해킹을 당해도 2차 방화벽이 있어 보안에 더 강해질 수 있다.

- SSL 암호화

- 들어가고 나가는 복호화/암호화를 해주어서 원래 서버가 하는 부담을 줄여준다.

- 속도와 안정성

- Cache Server를 붙이거나 SSL 하드웨어 가속기를 연동하는 등 아키텍처 측면에서 성능을 향상 시키기 용이

- CDN을 연동한다면 DDOS 공격을 효과적으로 방어하고 안정적으로 서비스를 제공할 수 있다.

- 신뢰성 증대

- 사용자가 증대하는 상황에 맞게 Web Server나 WAS를 유연하게 늘릴 수 있다.

참고

https://www.lesstif.com/system-admin/forward-proxy-reverse-proxy-21430345.html

포워드 프록시(forward proxy) 리버스 프록시(reverse proxy) 의 차이

Web Server와 WAS 에 대해 연동하려면 Reverse Proxy 에 대한 이해가 필수입니다.

www.lesstif.com

[Infra] 리버스 프록시(reverse proxy) 서버 개념

리버스 프록시(reverse proxy) 서버 개념

losskatsu.github.io

'Data Engineering' 카테고리의 다른 글

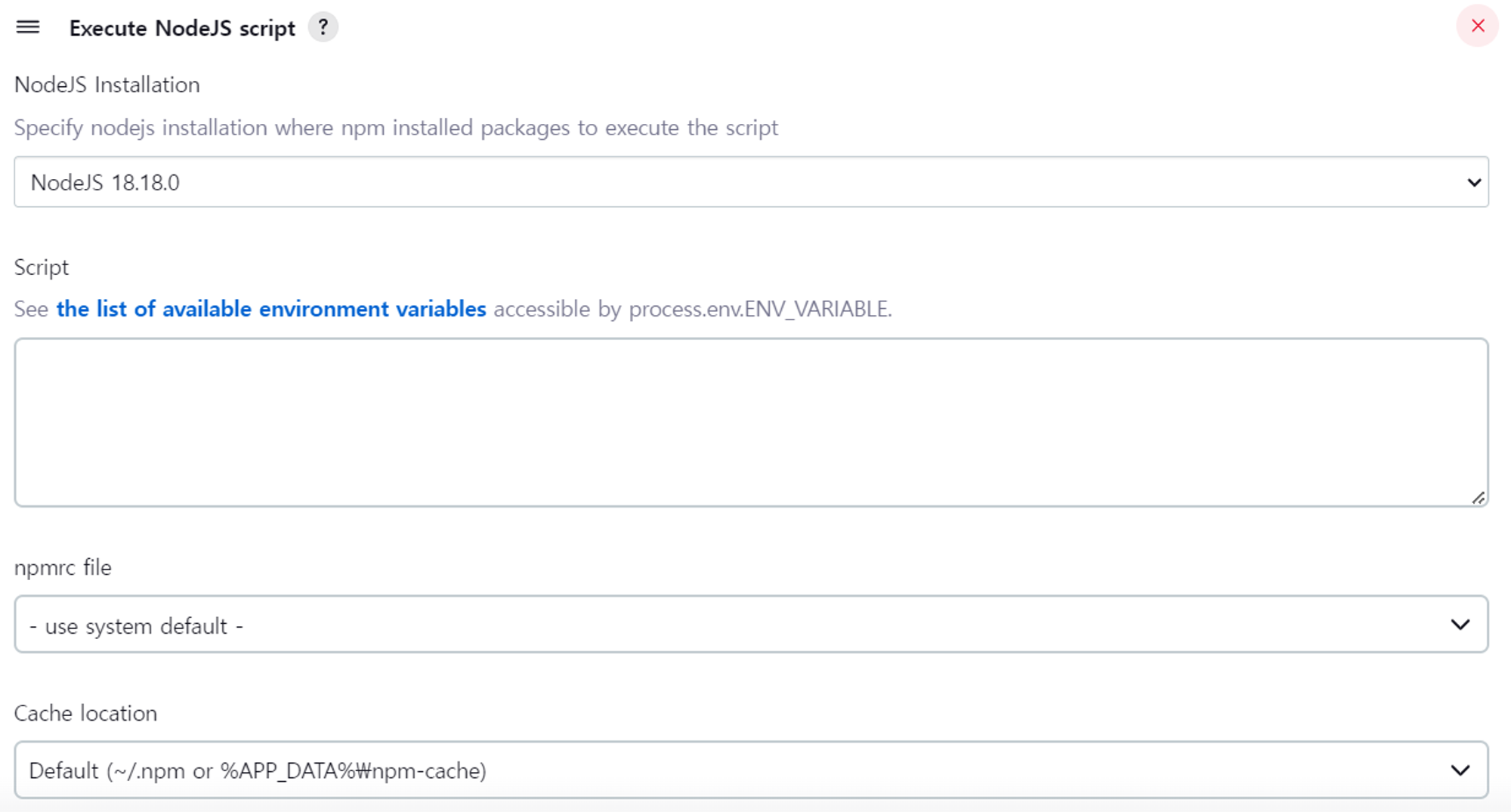

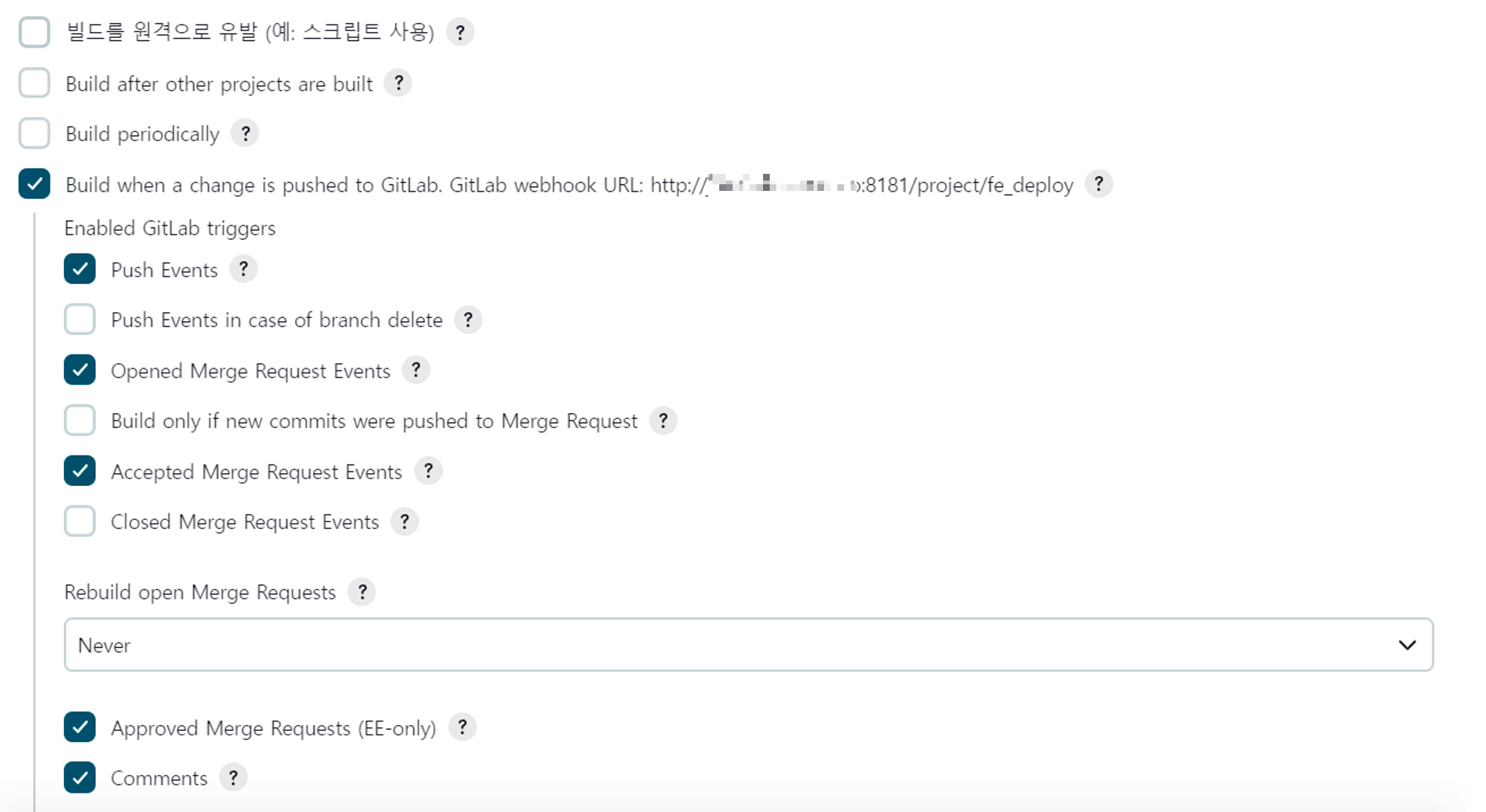

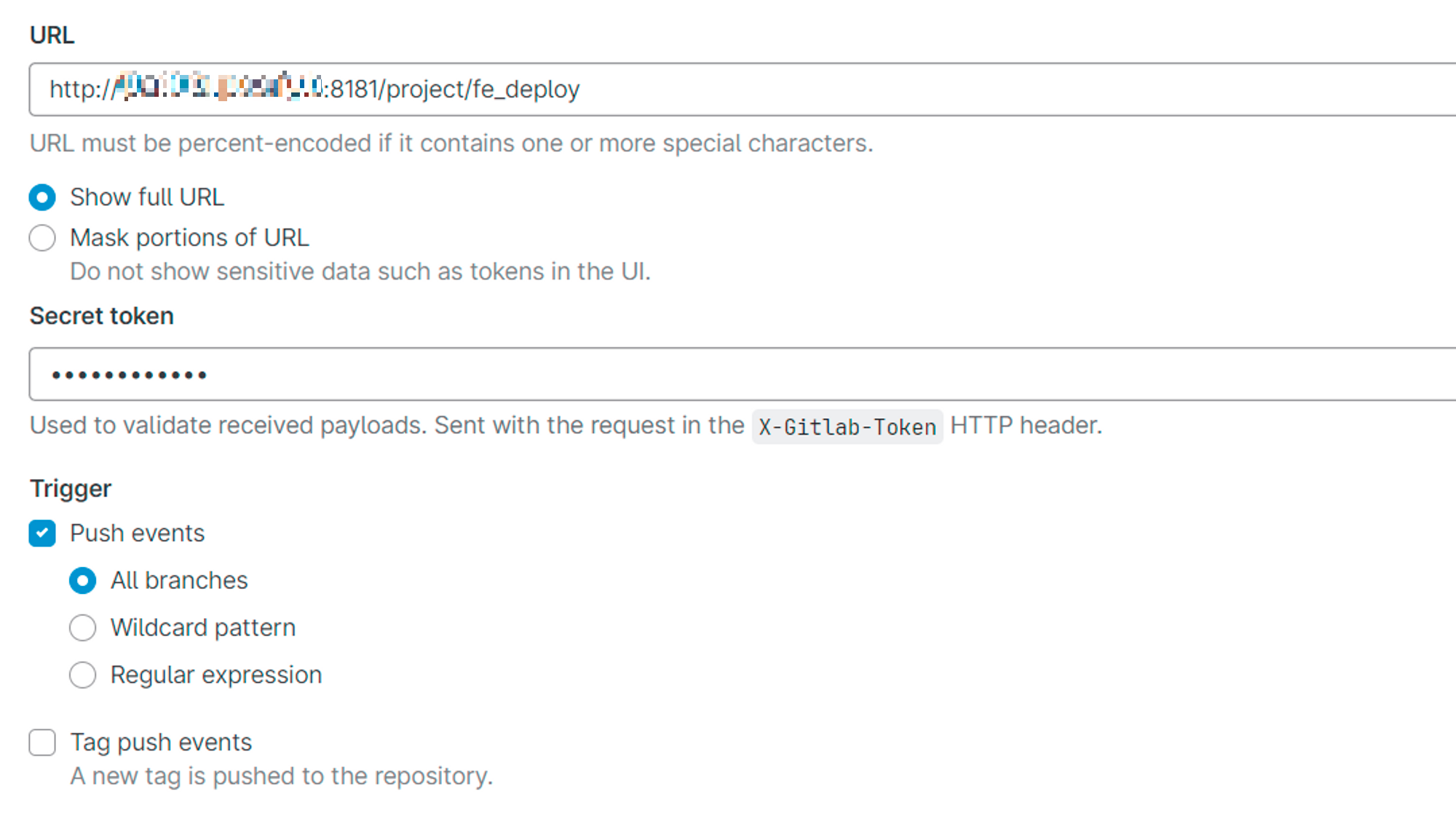

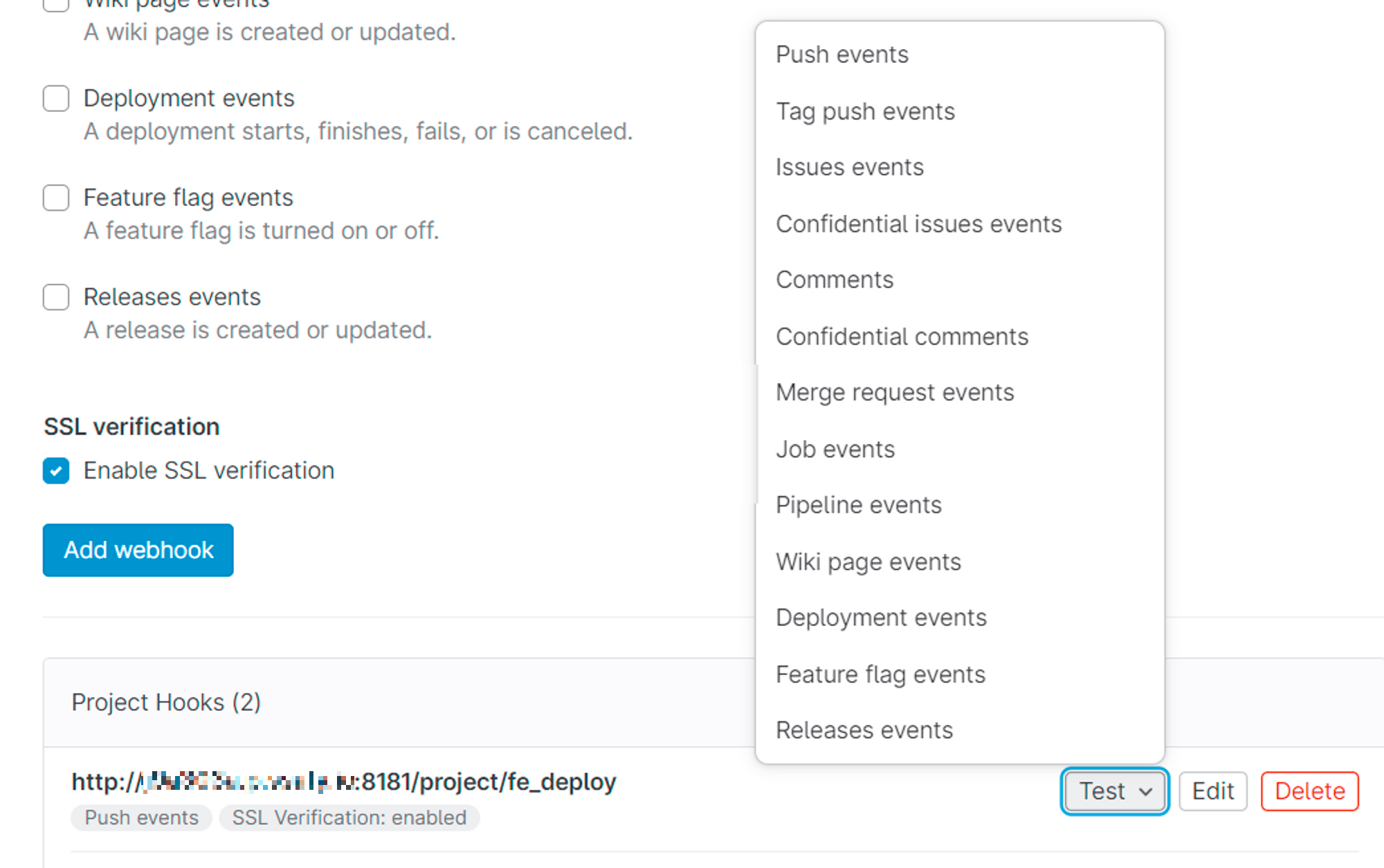

| [Infra] Vue.js CI/CD로 배포하기 (0) | 2023.09.28 |

|---|---|

| [Infra] CI/CD와 Jenkins (0) | 2023.09.28 |